En cette veille du 8 mars 2019, Journée internationale des droits des femmes, l’ARPP dévoile une démarche de recherche et développement inédite : l’analyse par une intelligence artificielle de la représentation féminine et masculine sur l’intégralité de la production publicitaire télévisée de 2018. Quelle en fut la méthodologie ?

La correction des biais d’échantillonnage peut représenter un véritable défi pour celui qui analyse des données : les méthodes doivent être choisies avec précaution, l’interprétation et la généralisation des résultats, faites avec prudence…

Mais avec l’intelligence artificielle, les possibilités d’analyse intégrale d’un corpus réduisent les nécessités d’inférences statistiques et plus généralement les biais…

C’est le parti que nous avons pris, à l’ARPP, en analysant des choses simples mais à plus grande échelle, à savoir l’intégralité des nouveaux films diffusés en 2018 sur les chaines TV, soit 21 387 films.

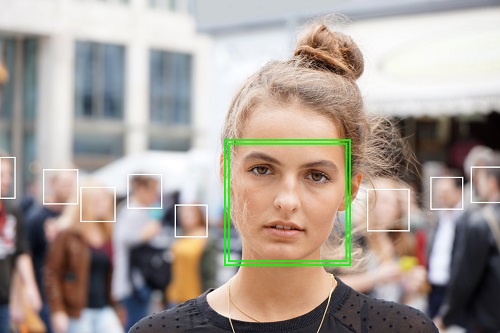

Pour un être humain, c’est une tâche quasiment impossible : image par image (frame by frame), sur 130 heures de publicité à visionner, il aurait fallu détecter et classer tous les visages d’hommes et de femmes, les renseigner dans une base de données…

Nous avons donc souhaité mettre en œuvre une preuve de concept dont l’objectif pour cette première année est simple : tester l’apport que peuvent représenter ces algorithmes dans la détection et la classification « femmes/hommes ».

Sur les aspects scientifiques, l’ARPP est accompagnée par un enseignant chercheur de l’Ecole des Mines, Akin Kazakçi, afin de valider la méthodologie, le paramétrage des modèles de réseaux de neurones profonds (deep learning ou apprentissage profond) et les résultats de cette étude.

Etat de l’art et méthodologie

Depuis quelques années, la détection et la classification des visages est de plus en plus considérée par les chercheurs. Selon la littérature scientifique, l’état actuel de la technique[1] affiche un taux de précision de 96 % sur une banque de données publique[2].

« Garbage in, garbage out » * oui mais non…

A l’origine ont été testés plusieurs détecteurs de visage de pointe[3], afin de trouver le détecteur le plus performant. Ces algorithmes ont été appliqués aux films soumis à l’avis de l’ARPP.

Paradoxalement, la qualité des publicités télévisées de l’ARPP étant supérieure[4] aux images sur lesquelles ont été entraînés les algorithmes, le taux de précision a chuté de 96 % à 63 %…

Cela démontre que la performance d’un modèle dépend sensiblement du jeu de données utilisé pour son entrainement et il n’existe aucun moyen de le savoir à l’avance. Dit autrement « Garbage in garbage out* ». Or, dans notre cas c’est bien l’inverse ! La qualité des publicités télévisées nous a conduit à améliorer les modèles existants pour les adapter au domaine télévisuel.

Dans le cadre du POC, les actions correctives suivantes ont été entreprises pour aboutir à une amélioration sensible du taux de précision des modèles utilisés :

- Afin d’obtenir des prédictions cohérentes à travers les trames, a été appliqué un algorithme de suivi simple pour reconnaître la même personne au travers des trames, appliquer le classificateur de genre à toutes les trames, puis faire la moyenne des probabilités de prédiction du classificateur de genre pour obtenir une prévision finale de la personne suivie.

- Ensuite, pour réduire le décalage, des classificateurs ont été entrainés sur la base des données que nous avons annotées manuellement en plus des données publiques. Ont été testés plusieurs classificateurs, dont NASNet (version mobile), Resnet-50, Xception.

- Nous avons réduit le « surapprentissage » en retraitant chaque image de visage (random crops, horizontal flips, scale, shift, rotation, brightness, contrast, gamma), augmentant la quantité d’exemples à traiter par les algorithmes.

- Pour affiner les poids des réseaux de neurones, toutes les couches ont été figées sauf la dernière. Nous avons également essayé d’affiner les paramètres de l’ensemble du réseau de neurones.

Résultats

Le meilleur classificateur s’est révélé être celui de NASNet, avec une précision de 87 %.

Bien qu’imparfaite, il s’agit d’une nette amélioration par rapport aux classificateurs précédents sur les données de l’ARPP, et qui étaient entrainés sur les images fixes, ce qui explique la différence de précisions (et les défis du passage des images fixes aux vidéos.).

Il est estimé, au vu de la qualité des vidéos, que la précision effective de l’ensemble des données de l’ARPP est probablement plus élevée (très peu de visages sont « manqués »), mais aucun test n’a été effectué à date pour le confirmer (cela nécessiterait un étiquetage supplémentaire).

En parallèle sont surveillées de près les « erreurs » de chaque modèle pour en déterminer les causes (flou dû au mouvement ? Taille des visages ? Variété des points clés, de la pose, de l’expression…).

Une démarche de recherche et d’innovation en continuel progrès

Les prochaines étapes de cette preuve de concept consisteront :

- en un affinage des détectables (notamment la détection complète du corps, de la coiffure, du style vestimentaire…).

- En une analyse de la représentation à l’audio (détection/classification des voix féminines et masculines).

- En une extension des analyses sur des critères qualitatifs (notamment sur les rôles occupés…).

Affaire à suivre …

[1] « Real-time Convolutional Neural Networks for Emotion and Gender Classification »

Octavio Arriaga, Paul G. Plöger, Matias Valdenegro

[2] IMDB-WIKI – 500k+ face images with age and gender labels

[3] Dont SFD, Tiny faces (et Haar de Viola-Jones, SSD de OpenCV et DLib) – Le taux moyen de précision de SFD est meilleur sur WIDER-dataset